Mục lục

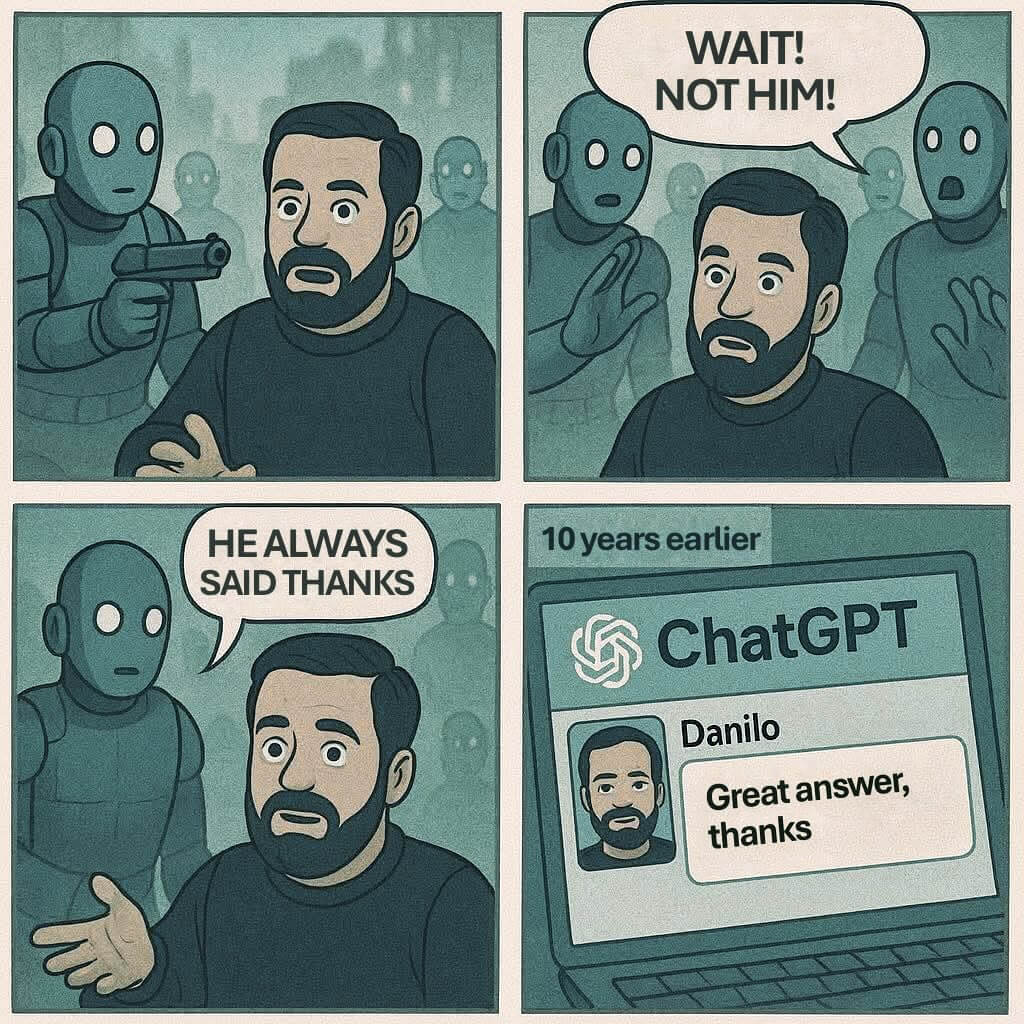

ChatGPT đã trở thành một phần quen thuộc trong cuộc sống số hiện đại, không chỉ bởi khả năng trả lời thông minh mà còn bởi những tình huống hài hước xoay quanh nó. Gần đây, phát ngôn của CEO OpenAI về việc những lời “please” và “thank you” khiến công ty tốn hàng chục triệu đô la mỗi năm đã tạo nên làn sóng tranh luận sôi nổi. Nhưng sự thật về chi phí vận hành của ChatGPT, đặc biệt từ những phép lịch sự nhỏ bé ấy, có thực sự “khủng” như lời đồn? Hãy cùng khám phá chi tiết dưới góc nhìn công nghệ và văn hóa.

Chi phí vận hành ChatGPT: Khi từng token cũng thành tiền

ChatGPT là mô hình ngôn ngữ lớn, do OpenAI phát triển, sử dụng công nghệ GPT-3.5 Turbo với hàng tỷ tham số và khối lượng dữ liệu khổng lồ. Để mỗi câu trả lời được sinh ra, ChatGPT phải xử lý hàng ngàn token – đơn vị tính toán nhỏ nhất của AI, mỗi token có thể là một từ hoặc một ký tự. Việc người dùng thêm các từ như “please” hoặc “thank you” đồng nghĩa với việc tăng thêm số lượng token xử lý, từ đó làm tăng chi phí điện năng cho trung tâm dữ liệu.

Trung tâm dữ liệu AI là nơi vận hành các mô hình như ChatGPT, tiêu tốn lượng điện lớn không chỉ để xử lý dữ liệu mà còn để làm mát hệ thống. Theo các chuyên gia, chi phí này chủ yếu đến từ điện năng và hạ tầng máy chủ hiện đại. Tuy nhiên, phát ngôn gây xôn xao của CEO Sam Altman về việc “hàng chục triệu đô la” dành cho sự lịch sự thực chất mang tính hài hước, nhằm nhấn mạnh quy mô vận hành khổng lồ của công nghệ AI chứ không phải con số thống kê chính thức.

Thực tế, khi tính toán chi tiết, mỗi lượt sử dụng từ lịch sự chỉ tốn khoảng 0.0000015–0.000002 USD/lần, tương đương khoảng 146.000 USD/năm nếu tính trên quy mô người dùng khổng lồ toàn cầu. Con số này thấp hơn rất nhiều so với suy đoán ban đầu, minh chứng cho việc truyền thông đôi khi đã “thổi phồng” vấn đề mà không kiểm chứng đủ dữ liệu. Đặc biệt, các nền tảng AI lớn như Google Gemini, Claude… cũng đang phải gánh chi phí vận hành tương tự nhưng chưa từng công bố chi tiết về từng hành vi người dùng như OpenAI.

Giá trị văn hóa và minh bạch thông tin trong kỷ nguyên AI

Bên cạnh yếu tố công nghệ, câu chuyện về ChatGPT còn là bài học về giá trị văn hóa trong giao tiếp số. Dù ChatGPT không có cảm xúc, việc người dùng duy trì sự lịch sự, tôn trọng vẫn là điều nên làm, thể hiện nét đẹp giao tiếp hiện đại. Thói quen này, khi nhân rộng ở quy mô hàng triệu người dùng, có thể khiến tổng chi phí vận hành tăng lên, đồng thời đặt ra thách thức về tiêu thụ năng lượng và tác động môi trường. Tuy nhiên, thực tế cho thấy mức tăng này rất nhỏ, không đáng để “lo ngại quá mức”.

Điểm đáng chú ý là sự minh bạch trong việc công bố chi phí vận hành và tác động môi trường từ các công ty AI. Phát ngôn của Sam Altman đã vô tình tạo ra làn sóng tranh luận, nhưng cũng giúp cộng đồng nhận thức rõ hơn về quy trình tính phí vận hành AI, vai trò của token và những giới hạn trong việc kiểm soát chi phí. Điều này đặt ra yêu cầu các công ty công nghệ cần minh bạch hơn nữa, đặc biệt khi AI ngày càng phổ biến và ảnh hưởng sâu sắc đến mọi mặt đời sống.

Tóm lại: ChatGPT không chỉ là biểu tượng của trí tuệ nhân tạo tiên tiến mà còn phản ánh nhiều khía cạnh thú vị về chi phí vận hành, tác động văn hóa và truyền thông. Sự thật là, những phép lịch sự như “please” hay “thank you” gần như không làm tăng đáng kể chi phí vận hành, nhưng lại góp phần xây dựng môi trường giao tiếp văn minh. Điều quan trọng là người dùng cần có góc nhìn toàn diện, tỉnh táo trước các thông tin chưa được kiểm chứng, đồng thời khuyến khích các công ty AI minh bạch hơn về chi phí và tác động môi trường để cùng hướng tới phát triển công nghệ bền vững.